/

19 dec 2025

De Dringende Noodzaak van Bedrijfsbrede AI-beveiliging

Ontdek waarom AI beveiligingsmaatregelen essentieel zijn voor het beheren van AI binnen organisaties. Leer hoe private AI-systemen beleid handhaven via architectuur in plaats van gebruikersnaleving.

/

AUTEUR

Subduxion

AI heeft stilletjes zijn intrede gedaan op de werkplek, niet primair door formele bedrijfsinzet, maar doordat individuele werknemers openbare AI-tools gebruiken voor dagelijkse taken. Van het opstellen van klantcorrespondentie en het samenvatten van interne documenten tot het verwerken van contracttaal en financiële gegevens, gevoelige bedrijfsinformatie wordt routinematig ingevoerd in systemen die buiten de beveiligingsgrenzen, toegangscontroles en audit-infrastructuur van jouw organisatie staan.

Dit is niet slechts experimentatie; het is ongecontroleerd systeemgebruik: een stille generator van institutioneel risico dat alleen met organisatie beleid voor acceptabel gebruik niet kan worden ingeperkt.

Het Probleem Is Niet Gedragsmatig, Maar Structureel

Publieke AI-tools, hoewel opmerkelijk toegankelijk, zijn ontworpen voor breed consumentengebruik. Hun optimalisatie is gericht op gebruiksgemak, niet op strenge bedrijfsgegevensbeheerkaders. Ze missen van nature kritische eigenschappen voor organisatiebeveiliging en naleving:

Contextspecifieke gegevensbehandelingsregels: Geen afdwinging van welke gegevens kunnen worden verwerkt

Integratie met identiteits- en toegangsbeheer (IAM) systemen: Geen rolgebaseerde toegang

Enterprise-grade beveiligingscontroles: Opereren buiten jouw vertrouwde omgeving

Auditsporen: Kunnen niet voldoen aan wettelijke of interne documentatie-eisen

Hoewel deze tools van onschatbare waarde zijn voor onderzoek, ideeënvorming en verkenning, zijn ze fundamenteel ongeschikt voor workflows met gevoelige gegevens, gereglementeerde besluitvorming of operaties die institutionele verantwoordelijkheid vereisen. Het UK government's "Mitigating ‘Hidden’ AI Risks Toolkit" wijst erop dat veel AI-risico’s voortkomen uit alledaagse, organisatorische factoren en de menselijke interactie met tools, wat de noodzaak onderstreept van een fundamenteel raamwerk dat verder gaat dan alleen technische waarborgen.

Dit cruciale onderscheid drijft de operationele noodzaak om van publieke AI-tools naar private AI-systemen over te gaan.

Private AI: Systeemniveau Controles, Verder dan Modelbezit

Een privaat AI-systeem opereert fundamenteel binnen de beveiligingsgrenzen van jouw organisatie. Het handhaaft beleid via architectuur, in plaats van alleen door naleving door gebruikers. Cruciaal is dat het naadloos integreert met jouw bestaande governance-infrastructuur: identiteitsbeheer, rolgebaseerde toegangscontroles, gegevensclassificatiesystemen en uitgebreide auditlogs.

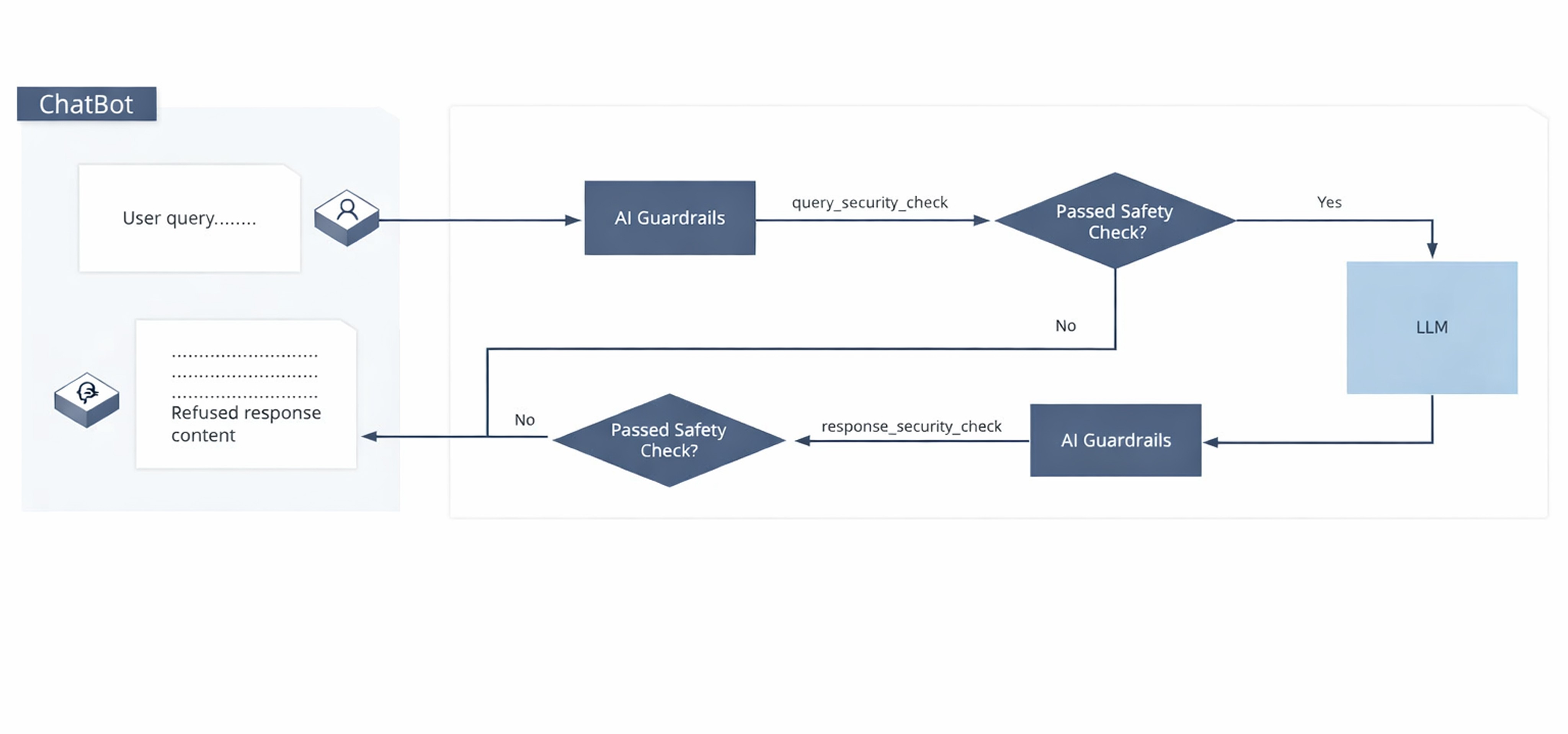

Het implementeert vooral waarborgen.

Waarden: Harde Afdwinging, Geen Zachte Richtlijnen

Waarden zijn ingebouwde, systeemniveau controles die onafhankelijk van gebruikersinput of -intentie werken. Ze functioneren als kritieke inspectielagen tijdens de AI-interactie:

Voorverwerkingscontroles:

Welke gegevens worden ingediend?

Worden ze geclassificeerd als gevoelig of beperkt?

Is dit specifieke gebruiksgeval toegestaan voor deze gebruikersrol in deze context?

Voldoet het verzoek aan de toepasselijke gegevensverwerkingsvereisten (bijv. gegevensminimalisatie)?

Naverwerkingscontroles:

Bevat de AI-uitvoer informatie die niet in dit formaat onthuld mag worden?

Impliciteert het een beslissing, beoordeling of aanbeveling die gedocumenteerd menselijk toezicht vereist?

Voldoet het aan de gedefinieerde kwaliteits- en nalevingsdrempels?

Als een controle faalt, blokkeert het systeem de interactie volledig of routeert het voor verplichte menselijk toezicht. De beslissing is programmeerbaar, niet discretionair. Dit is geen pure eindpuntbeveiliging of contentfiltering; het is robuuste workflow governance die precies wordt toegepast op AI-interacties. Zoals GitHub benadrukt, bouwen duidelijke, praktische beleidsregels en een raamwerk voor gelaagd gebruik van tools het vertrouwen op dat nodig is voor veilige AI-adoptie.

Waarom Dit Belangrijk Is: Realistische Organisatiescenario's

Deze alledaagse voorbeelden benadrukken de urgentie:

Personeelszaken: Een team uploadt kandidatenprofielen om de screening te versnellen en stelt onbedoeld beschermde persoonlijke kenmerken bloot aan een publieke AI-dienst zonder specifieke controles voor PII. Het "verborgen risico" hier is onbedoelde blootstelling van gegevens door een gebrek aan structurele afdwinging (gov.uk).

Juridische Afdeling: AI wordt gebruikt om verplichtingen uit een conceptcontract te extraheren, waarbij niet wordt erkend dat de vertrouwelijkheid van het contract externe verwerking verhindert.

Financiële Afdeling: Een AI wordt gevraagd kwartaalresultaten samen te vatten voor interne communicatie, waardoor onbedoeld niet-openbare financiële informatie wordt onthuld in de output.

Compliance Officer: AI stelt een regelgevingsreactie op, zonder te weten dat de reactie kan worden geïnterpreteerd als een formele positie die gedocumenteerde menselijke goedkeuring en toezicht vereist.

In elk geval is het risico niet te kwader trouw; het is een structurele kloof - de afwezigheid van systeemniveaubeveiliging die is afgestemd op de bestaande risico- en nalevingskaders van de organisatie.

Een Bestuurlijk Vereiste, Geen Keuze voor Technologie

De architectuur van op waarborgen gebaseerde private AI sluit perfect aan bij erkende mondiale AI-governanceprincipes, waaronder die uiteengezet door Microsoft voor verantwoord AI praktijkgebruik:

Gegevensminimalisatie: Alleen gegevens die nodig zijn voor de specifieke taak worden verwerkt.

Doelbeperking: AI-gebruik is strikt beperkt tot gedefinieerde, geautoriseerde gebruiksgevallen.

Menselijk Toezicht: Kritieke beslissingen blijven onderworpen aan gedocumenteerd menselijk toezicht en interventie.

Verantwoording: Elke interactie wordt gelogd, traceerbaar en volledig controleerbaar.

Organisaties zijn niet verplicht specifieke modellen of leveranciers aan te nemen. In plaats daarvan moeten ze ervoor zorgen dat AI-gebruik binnen hun operaties wordt beheerst met dezelfde striktheid die wordt toegepast op andere gevoelige operationele systemen. Het Microsoft Frontier Governance Framework benadrukt bijvoorbeeld beveiligingsmaatregelen, veiligheidsmitigaties en monitoring als essentiële voorwaarden voor veilig en betrouwbaar AI-gebruik, vooral voor geavanceerde modellen.

Zonder deze robuuste AI-waarborgen blijft AI een ongecontroleerde capaciteit - een digitale "schaduw IT" die onvoorspelbare aansprakelijkheden introduceert. Met waarborgen transformeert het in een beheerst systeem.

Dit is niet slechts een technische onderscheid; het is een institutionele noodzaak.

De echte vraag is niet of jouw organisatie AI zal gebruiken. Het is of dat gebruik wordt beheerd op een manier die in overeenstemming is met hoe je al toegang, documentclassificatie, besluitregistratie en derde-partij gegevensstromen beheert. Private AI-systemen maken deze essentiële afstemming architectonisch afdwingbaar, grenzen stellend door systeemontwerp, ongeacht individuele gebruikersbewustzijn of intentie. Dit is de basis van operationele AI-governance.